| Moderador del foro: ZorG |

| Foro uCoz Ayuda a los webmasters Promoción del sitio Promoción y optimización de la web |

| Promoción y optimización de la web |

Así que al fin y al cabo empiezo a escribir el tema acerca de cómo se promociona el sitio web.

Primero de todo trata de ofrecer a los usuarios de tu página web sólo una información bien útil. ¡Esa es la garantía de éxito! Cuan más valiosa es la información, será más fácil promover (o promocionar, aquí eliges tú ya) tu sitio web. Ausencia de errores ortográficos. Aplica los programas ortográficos correspondientes. Mínimo 300 palabras en una página. Si el texto contiene una información útil, entonces es rico en palabras claves.

Todos los factores que influyen a la posición del sitio web en el sistema de búsqueda, pueden estar divididos en los interiores y exteriores. Los interiores son los que están controlados por el propietario de la web (texto, diseño etc.).

¿Qué quiere decir la optimización del sitio web? La optimización es el aumento de la eficiencia con la cual el sitio web va cumpliendo sus tareas. Las funciones típicas son las representativas (PR), de venta (B2C) y de generación de vendedores potenciales (lead generation, B2B). Respectivamente, en el primer caso la medida de la eficiencia del sitio web es su imagen y “visibilidad” del recurso, en los demás – volumen de ventas o número de los vendedores potenciales.

PageRank – es un método de Google para medir la “importancia” de una página web. Cuando todos los demás factores, tales como los tags Title y palabras claves, están considerados, Google aplica PageRank para corregir los resultados a que los sitios web más “importantes” asciendan en la página de resultados del buscador de un usuario.

Catálogos blancos son los que colocan el enlace directo hacia tu página web sin que exigieran de ti a que coloques un vínculo de retroceso. Registro en estos catálogos es un medio muy eficaz para mejorar la posición de tu página web en los sistemas de búsqueda por las consultas de búsqueda necesarias.

La participación en los programas de afiliados es uno de los mejores métodos para cobrar a los web-masters. Francamente, este programa está basada sobre la exposición de los banneres, anuncios de publicidad etc. en los sitios web de los participantes. A propósito, la publicidad se paga. Se paga bien (a veces). Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

FUERZA DE LAS PALABRAS CLAVES

Para elegir correctamente las palabras claves, se puede hacer lo siguiente: 1. Utiliza estas palabras en los títulos de tus páginas; TABÚ DE LOS SISTEMAS DE BÚSQUEDA 1. No repites las palabras claves iguales en keywords más de 3 veces. También eso toca a las palabras con la ráiz común (parónimos). A los sistemas de búsqueda no les gusta;

Generalmente, si vas creando un sitio web interesante y honesto, si no vas a utilizar las porquerías para su promoción – no tendrás problemas con la indexación. Aquí no hace falta prodigarse pues sólo puedes estropear. ¡Éxitos a todos! Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Así que quieres optimizar tu web con tus propias furzas. Te debo advertir que es una cosa bastante complicada y tendrás que armarte de paciencia y tiempo libre para conseguir los fines planteados, la franca. Siguiendo nuestras indicaciones y consejos podrás optimizar tu portal web y colocarlo en el TOP de los motores de búsqueda bastante rápido.

Optimización del sitio web significan las acciones con los elementos y estructura de la web y elementos que la rodean, que llevan a la mejora de las posiciones en la exposición de los resultados de la búsqueda por las solicitudes del usuario. Hablando más sencillo, optimización es un conjunto óptimo de tales parámetros como Volumen del texto en la página, Número de palabras claves en la página, Estructura y navegación de la web, Significado de los tags “TITLE” y “ALT”, meta-tags ”Description” y “Keywords”. Existe una opinión: más páginas en la web quiere decir “mejor”. Y que aumentando el número de las páginas, mejoramos su posición en el motor de búsqueda. Pero en el Internet existe un montón de los sitios web de “mil páginas” que según las solicitudes no representan interés alguno en los usuarios de la Red aunque existen un plazo bastante largo. Claro está que una adición paulatina de nuevos materiales y páginas es necesaria y esto es considerado por los motores de búsqueda como un lógico desarrollo del recurso que da ciertas ventajas durante el ranking. Por eso te aconsejo que te acostumbres colocar cuanto más información útil y cualitativa en la web – noticias, comunicados de prensa, artículos, consejos útiles etc. De todo modo eso será provechoso y dará sus frutos. Volumen del texto en la página: los motores de búsqueda aprecian los sitios web llenados con un contenido informativo. En cualquier caso hay que tratar de ir aumentando el contenido textual de la web. Si no para los motores de búsqueda, entonces para los visitantes de tu web – sin duda alguna.

Comúnmente el sitio web tiene el menú de navegación. Las webs estáticas visitadas por el motor de búsqueda, tienen una cierta ventaja ante los sitios web con núcleo dinámico, pues se indexan más fácil y rápido. Si tu web es dinámica, crea un SiteMap que contenga todos los enlaces del menú hechos a mano mediante HTML. Esto va a aumentar la usabilidad de la web y mejorar la cohesión de enlaces para los motores de búsqueda. Cabecera de la página

Métodos inadmisibles de optimizar el sitio web: 1. disfraz de las páginas, o sea, al motor de búsqueda se entrega un material y al usuario – otro; 2. texto que tiene el mismo color que el fondo de la página o una reducción deliberada del tamaño de las letras hasta que sea invisible por el usuario (se utiliza para abundar la página con las palabras claves que sean invisibles por los usuarios pero sí visibles por los motores de búsqueda); 3. redirección automática de la página encontrada a otra. Además, las redirecciones complican el análisis del sitio web por los robots; 4. intercambio de los enlaces para dar más importancia y seriedad a las páginas de la web. No obstante, no todos los motores de búsqueda lo perciben como spam. Aunque no se recomienda abusar de esto; 5. utilización de los enlaces-imágenes gráficos invisibles por los usuarios (1x1 pxl) es considerado por los motores de búsqueda como una tentativa de engaño. La utilización de tales métodos de optimización “fraudulentos” puede provocar el baneo de la web, o sea, a su exclusión forzada del índice (base de datos) del motor de búsqueda.

1. evita los subcatálogos. Si tu web tiene pocas páginas (digamos, hasta 20), ubícalas en el directorio raíz. Para los motores de búsqueda tales páginas representan máxima importancia; 2. hay optimizar cada página para una frase clave concreta. A veces es posible elegir 2 o 3 frases semejantes, pero si tratas de optimizar la página con 5 o más frases – resultado será nulo; 3. presta máxima atención a la página de inicio: es ella que tiene máximas posibilidades de ocupar los altos lugares en los motores de búsqueda; 4. no utilices imágenes en vez del texto. Aquí recordemos que la parte superior de la web es la parte más preciosa y está destinada para los motores de búsqueda. Si estás convencido de que arriba debe haber logotipo de tu compañía (firma, empresa, sociedad etc.), trata de combinar la imagen gráfica con un texto simple; 5. navegación no debe pasar a través de los scripts; 6. si la navegación está realizado en forma de gráfica, por lo menos no olvides inscribir los parámetros correctos del tag ALT en los códigos de las imágenes de los botones; 7. en los scripts dinámicos a veces se utiliza el identificador de sesiones. Con su ayuda es muy cómodo recoger los datos estadísticos acerca de la conducta de los visitantes del sitio web, pues cada usuario al entrar en el sitio obtiene un parámetro único &session_id= que se añade a la dirección de cada página visitada de la web. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Posicionamiento y publicidad web para principiantes

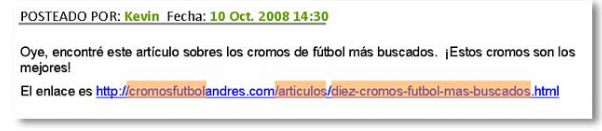

Posicionamiento es el lugar mental que ocupa una marca o empresa en la mente del consumidor o cliente. En nuestro caso no solo es esto, es el lugar “físico” que ocupa nuestro sitio. Imaginemos nuestra página web como un negocio, lo creamos y lo colocamos dentro de las quinientas cuadras de negocios del rubro, tenemos mexicanos por un lago y rusos por el otro. ¿Qué nos hace distintos?, ¿Cómo logramos visitas? Lo más lógico es que el cliente no caminara más de una cuadra hasta entrar y comprar lo que busca, eso nos obliga a estar primeros… en los primeros diez negocios. Lo segundo, un cliente con tantas posibilidades solo entrará si el cartel de la puerta dice claramente lo que estas vendiendo y por último al ingresar la vidriera debe ser impactante pero la atención rapidísima. Si ingreso y los productos tardan más de quince segundos en “aparecer” me voy. Tenemos todo esto y aún más: esta comprobado que muy poca gente ingresa a un sitio directamente con su dominio, en la mayoría de los casos realiza una búsqueda antes, por ejemplo en vez de poner www.hotmail.com, ingresa a Google y coloca Hotmail y hace clic en el primer enlace (que es justamente www.hotmail.com) , ¿y si su sitio no es el primer enlace? Así (casi) nace el posicionamiento web, básicamente lograr que su sitio este en los primeros lugares de un buscador, cuando el usuario (su cliente) realice una búsqueda especifica. Aclaramos lo de “búsqueda especifica” por que es importante entender que el posicionamiento esta relacionado íntimamente con palabras o frases. Claro esta, el cliente busca: “viaje cancun” y comienza la lucha. Agencias de viajes, sitios turísticos, enciclopedias, un sin fin de sitios que están relacionados con “viaje cancun”. Existen varias técnicas y métodos que se deben tener en cuenta para lograr que un sitio “compita”, así como muchas cosas que nose deben hacer, por que, aparte de ser competencia desleal y darle muy mala publicidad a su sitio, están penalizadas por Google (su sitio nunca más estará indexado a este buscador, es decir no aparecerá en ningún tipo de búsqueda). Este documento no intenta ser una guía para un webmaster, simplemente quiero sumergirlos (unos 5cm) en el mar del SEO y el posicionamiento web. Lo primero es lo primero (para sentirnos importante) hay que saber que significa: • SEO: Search Engine Optimization, optimización para motores de búsqueda. Este concepto involucra tanto las técnicas de posicionamiento aplicadas directamente en los buscadores o motores de búsqueda, como el análisis y diseño web. No se confundan con Web CEO, que es un soft de “ayuda” para el posicionamiento. Los puntos principales a tener en cuenta a la hora de buscar competir, tanto para el desarrollador web como al encargado de la información web (lo que llamamos director web) son: • 1ro. Diseñar el contenido del sitio acorde a lo que queremos vender, por ejemplo si hacemos un sitio de turismo, es importante hablar sobre quienes somos o los años que llevamos trabajando para usted, pero aun más importante es mostrar que vendemos, como lo vendemos y que nos diferencia de la competencia. En los sitios que trabaje siempre puse en esta tarea a gente especializada, o conocedora de marketing y publicidad. Y aquí nacieron los conocidos: FFA, ‘link farms’ (granjas de enlaces) sitios creados para vender enlaces, totalmente amonestados por Google. Es importante tener en cuenta que más de 100 enlaces en un pág. esta muy mal visto. Aquí les dejo algunos conceptos, para no cometer un grave error Cloaking o encubrimiento, se crea un sitio que muestra un contenido al usuario y otro totalmente distinto a los buscadores. Un caso particular es son los doorway que poseen un diseño para los robots y cuando ingresa un visitante por javascript u otro método similar abre otra paguina con información realmente “legible” para un ser humano. Texto y enlaces ocultos: lo hacen del mismo color del fondo, en capas invisibles, etc. Aquí les paso dos enlaces que rescate de un documento relacioando al tema. Colocan un id invisible llamado fantasma, y “comentarios” que es texto oculto normalmente usado para comentar el código a fin de llevar un correcto diseño y desarrollo entre diferentes personas. Esto lo hace en su sitio como en todos los desarrollados, esto no solo puede generar que google no indexe mas el sitio de sus clientes, sino dañan la imagen del mismo. Coloca enlaces ocultos a su pagina en todas las de sus clientes. - Páginas duplicadas: Son dos o más sitios llenos de texto, enlaces y cargados de palabras claves, pero al ingresar nos llevan a una tercera pagina que contiene lo que quieren vender. También existen los Spam en weblogs, libros de firmas,etc. Esta de más decir que el abuso de palabras claves y vender enlaces esta penalizado. Existen muchas penalizaciones, y tenes que estas al tanto de todas por eso te recomendamos siempre leer sobre ellas en el sitio oficial de Google, como en muchos dedicados al tema. Hay muchos sitios de directorios que dan de alta tu sitio gratis o por intercambio, aquí tenemos que apuntar y claro a tratar de aparecer en Yahoo! y DMOZ que son el puente a otros sitios importantes. Backlinks: es la cantidad de paginas que indexa un sitio. Para saber que sitios te indexa en Google: link: http://www.tusitio.com y Yahoo: http://siteexplorer.search.yahoo.com Finalmente, Google muy rara vez te indexara nuevamente si te penalizo de todos modos deja un formulario para que te comuniques con ellos: http://www.google.com/support/bin/request.py Creo que hasta ahora les dí un básico y pequeño recorrido, quería proporcionarles una idea de este tema, Internet esta lleno de información y sobre esto hay mucho y muy bueno. Para terminar: el trabajo de posicionamiento no es simplemente hacer que tus amigos entren sin parar a un sitio para darle hits, o darlo de alta en todos lados, es un proceso largo, muy bien analizado y pensado. Con base en un estudio de marketing, acompañado por mecanismos de publicidad no necesariamente atados al posicionamiento. Esto y mucho más muestran que este trabajo debe ser hecho por expertos, gente que trabaja en este tema y se capacita todo el tiempo. Si te interesa, estudia, lee mucho y trabaja sobre un sitio demo antes de tomar la marca de una empresa en tus manos. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Aqui os dejo mi opinion sobre lo que acaba de escribir nuestro amigo.

El PR es un tema muy discutido por los webmaster ultimamente a pesar de que los inginerios de google no recomienda que hacemos spam de nuestrsa entrada PAGINA DE INCIO, sea que no nos ayuda mucho en dar de alta nuestro sitio en 1000 directorios o obtener link hacendo spam. Y para hablar de este tema de SEO ahi muchaaas cosas que decir, por cierto acabo de leer un libro que se llama Posicionamiento en los buscadores cuando tendre un rato os hare un rezume y dejare algunos enlace de algunos blog sobre SEO que sigo. Saludos amigos. |

Gestor de contenidos y Posicionamiento en los buscadores (CMS y SEO) Cómo aprovechar su gestor de contenidos (CMS) para tener una web bien posicionada en buscadores. Los gestores de contenido y el SEO • Facilitar la generación y edición de contenidos para la Web por parte de personal sin formación específica en programación. Los gestores de contenidos o CMS son herramientas de software que permiten descentralizar las labores de mantenimiento del contenido de un portal, de forma que personal no técnico de los distintos departamentos de una empresa puede añadir, editar y gestionar su propio contenido en una Web corporativa. CMS y posicionamiento en buscadores: ¿una simbiosis imposible? Entre los problemas que, desde el punto de vista de la optimización para el posicionamiento en buscadores, aparecen de forma recurrente en los portales soportados por sistemas gestores de contenido, destacan los siguientes: • URLs dinámicas: los buscadores limitan en ocasiones el número de variables dinámicas presentes en las URLs que indexan. Las páginas generadas por muchos gestores de contenidos incluyen frecuentemente un elevado número de variables dinámicas en su dirección URL. Resulta, pues, paradójico que precisamente sean aquellas empresas que más recursos invierten en el mantenimiento y generación de nuevos contenidos para sus portales las que, al mismo tiempo, menos se beneficien del volumen que dicho tráfico podría movilizar debido a una pobre implementación de sus sistemas de gestión de contenidos, desde el punto de vista del posicionamiento en buscadores. Un fallo que, en muchos casos, no se debe a carencias de la herramienta en sí, sino a un desconocimiento por parte de los técnicos que la implementan de la importancia que tiene que los contenidos generados por ella puedan ser competitivos en los buscadores. Hacer del gestor de contenido la mejor herramienta SEO • Emplear código valido según W3C: los gestores de contenido parten de plantillas prediseñadas, que los usuarios no pueden alterar, para generar las nuevas páginas. Si validamos el código de estas plantillas en origen, nos aseguramos de que las páginas generadas a partir de ellas contendrán también código válido. El empleo de código válido asegura que la página se mostrará correctamente en los distintos navegadores y que los buscadores serán capaces de rastrearla sin problemas. Lo mejor de ambos mundos Las grandes empresas cuentan con la materia prima favorita de los buscadores: contenido abundante, original, dinámico y de rápida actualización. Aprovechemos toda la capacidad de los gestores de contenidos para extraer el máximo rendimiento de la inversión que efectúan en su presencia en la Red. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

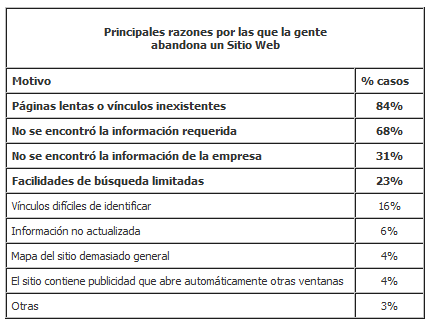

Las 8 principales razones por las que la gente abandona una página Web Si nos permiten hacer uso de la expresión coloquial, "No te dejo por feo, sino mas bien por pobre", pareciera ser la frase más apropiada para comprender la razón principal por la que las personas que navegan en Internet abandonan o no visitan las páginas Web. Abandonar un sitio por razones de un mal diseño gráfico no está dentro de las principales razones de por qué la gente decide cambiar de un sitio a otro, según encuestas realizadas en los Estados Unidos en los últimos años. Esto es importante saberlo porque estamos dedicando mucha atención a los aspectos de diseño gráfico del sitio y descuidando factores mucho más importantes como el propio contenido, facilidades de navegación y los tiempos de acceso de las páginas Web. La razón que está detrás de esta natural tendencia a centrar nuestra atención en aspectos de diseño gráfico, es que estamos todavía muy acostumbrados a la tradicional publicidad en periódicos, revistas y folletos promocionales. Sin embargo, estas técnicas de diseño no son directamente heredables al Web, donde el contenido y la funcionalidad deben estar por encima del diseño gráfico. Con esto no queremos decir que su Sitio Web no pueda ser estético, sino mas bien que debe Usted preocuparse en primera instancia por satisfacer las necesidades de contenido y funcionalidad, y si los recursos humanos y financieros lo permiten, dedicarse entonces a optimizar el diseño gráfico. Sin duda interesantes conclusiones las que arroja este estudio. Un punto muy importante es que muchos de estos errores se pueden prevenir a tiempo, pero desafortunadamente la mayoría de los empresarios y directivos toman sus decisiones sin antes consultar a los especialistas. Páginas pesadas Por ser de gran impacto visual, muchos desarrolladores en el mundo están cayendo en un uso indiscriminado de la animación gráfica con la venia de empresarios y ejecutivos responsables de los proyectos, a quienes no parece incomodarles la lentitud de acceso a sus sitios. Páginas de escaso contenido No existe información de la empresa Facilidades de búsqueda limitadas Otros factores en contra Por último, queda demostrado que la gente no gusta de la publicidad en línea cuando ésta rebasa los límites razonables. La apertura indiscriminada de ventanas para promoción de bienes y servicios puede ser una razón más para dar un clic y alejarse inmediatamente del sitio. En resumen, el estudio apunta una vez más a la necesidad por la sencillez, claridad y acceso rápido, como factores clave para un diseño Web exitoso. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Principios para la Optimización en Buscadores

En nuestro día a día de vez en cuando nos contactan nuestros clientes para preguntarnos acerca del posicionamiento y la optimización en los buscadores. La mayoría de las veces, nuestro cliente ya ha sido abordado por un Consultor de SEO (Search Engine Optimisation / Optimización en Buscadores) quien trata de venderle, por mucho dinero, la optimización en los buscadores. La firma de SEO promete “garantía de estar en las primera posiciones” y la “adición a 500.000 buscadores y directorios”. Muchos dueños de sitios son contactados regularmente por este tipo de compañías estafadoras, y es entendible que muchos piquen el anzuelo y comiencen a pagar por “las primeras posiciones y la adición a todo [buscador]”. Después de todo, ¿quién no quiere que su sitio esté bien posicionado en los buscadores? En un intento de ayudar a algunos y evitar que paguen por una optimización innecesaria en los buscadores, me gustaría compartir lo que he hecho para lograr muy buenas posiciones en los buscadores, tanto para este sitio como para los otros. Primero, déjenme decir que no todos los consultores de SEO son estafadores – hay muchas firmas respetables en el negocio. Sin embargo, cualquiera que prometa “garantía de estar en las primera posiciones”, “adición a 500.000 buscadores y directorios”, “resultados instantáneos” o “primeras posiciones permanentes” es probablemente un estafador. No hay manera de que alguien garantice que tu sitio obtenga la posición número uno a menos de que esa persona controle los resultados del buscador, o que la primera posición sea por una palabra o frase que sólo exista en tu sitio, por supuesto. Lo que me llama la atención, cada vez que pienso en lo que he hecho para obtener buenas posiciones en los motores de búsqueda, es lo mucho que el SEO tiene en común con la accesibilidad, usabilidad y un marcado [HTML] de alta calidad –los principios de los estándares Web. Esto lo hace aún mucho mejor: haciendo tu sitio más accesible y usable para las personas, y usando un marcado [HTML] válido y semántico [con significado], también lo hará más atractivo para los robots de los buscadores. Considera las guías que describo aquí como un nivel básico de SEO –pruébalo primero y si aún no obtienes los resultados que quieres, entonces busca la ayuda de una firma acreditada en optimización para los buscadores. Si contactas a alguien para que optimice tu sitio, pregúntale qué es lo que le harán a tu sitio. Si te sugieren métodos sospechosos, se muy cuidadoso. Ellos pueden hacer que seas penalizado o aún peor, que seas sacado de los buscadores. De otro lado, si su sugerencia incluye lo que te estoy sugiriendo aquí, probablemente harán un buen trabajo. 1. No hay atajos También necesitas paciencia. Los resultados no llegan de la noche a la mañana. Si estás trabajando en mejorar el posicionamiento en los buscadores del sitio de un cliente, probablemente deberías explicarle esto como primera medida. 2. Escribe buen contenido Un buen contenido para mi es aquel texto que sea real y gramáticamente correcto, aunque esto no es necesariamente obligatorio para toda tipo de sitios. Y no importa de lo que sea tu sitio, el contenido necesita ser único y/o lo suficientemente específico como para ser atractivo a la gente. Más específicamente, necesita ser útil a la gente que quieres que encuentre tu sitio. Con un buen contenido logras que tus visitantes vuelvan. Y aquellos a quienes les guste tu contenido eventualmente vincularán tu sitio, y el tener muchos vínculos que provengan de afuera es algo muy bueno para el posicionamiento en los buscadores, especialmente si esos vínculos son de sitios altamente posicionados. Estrechamente relacionado con el buen contenido es el contenido reciente. El adicionar nuevo contenido regularmente, le da a tus visitantes una razón para volver. Los robots de los buscadores también visitarán tu sitio más a menudo una vez que se den cuenta que actualizas regularmente, lo que significa que cada nuevo contenido que adiciones será indexado más rápido. Cuando se está trabajando para un cliente, el crear contenido de calidad es rara vez responsabilidad del diseñador web. A menudo, el cliente quiere escribir su propio “copy”, lo cual está bien si es bueno en eso y se dedica a adicionar nuevo contenido. En mi experiencia, es raro el caso que sea así. Si es posible, trata de que el cliente se de cuenta que deben contratar a alguien para que le ayude a escribir o al menos que les ayude a editar lo que han escrito. En todo caso, hazles saber claramente que no pueden esperar altos posicionamientos consistentemente sin un buen contenido. 3. Piensa en escribir correctamente [buena ortografía] No me gusta la idea de intencionalmente escribir mal las palabras, puesto que va contra mi definición de “buen contenido”. Si tienes dentro de tu contenido palabras que se puedan escribir de varias maneras [diferente ortografía] o que se escriben comúnmente mal, y son parte importante de tu contenido, es decir, que sean palabras claves, considera adicionar un glosario o algo similar en la página donde incluyas la mayoría de las variaciones de esas palabras. 4. Escribe títulos de página descriptivos Debido a esto, el título es uno de los elementos más importantes de la página. Algunos argumentan que es el más importante. Cuando se trata del orden del texto en el título, he encontrado que lo siguiente funciona bien: Titulo del Documento | Nombre de la sección | Nombre del sitio o la compañía Basada en esta discusión un tiempo atrás, este es probablemente uno de los mejores formatos para el texto en un titulo accesible. Nuevamente, la accesibilidad y el trabajo en SEO juntos. No importa lo que hagas, no uses el mismo título para todos los documentos. Haciéndolo harás el trabajo más difícil para los buscadores, para la gente que navega a través de los resultados en un buscador y para los visitantes para identificar de qué se tratan tus páginas. 5. Usa encabezados [headings] reales Si no puedes usar texto real, dale un vistazo a la variedad de técnicas de reemplazo con imágenes o flash disponibles. Ten cuidado que hay un pequeño riesgo al hacerlo. Debido a que estas técnicas de reemplazo involucran el esconder el texto, es teóricamente posible que los buscadores te penalicen. Actualmente ese riesgo parece ser muy pequeño, pero no digas que no te lo advertí si llega a pasar. 6. Usa URLs amigables para los buscadores En lugar de eso, utiliza URLs amigables para los buscadores y legibles para las personas [Ej: www.sitio.com/productos/producto1.asp]. Ayudará tanto a tu posicionamiento como a tus usuarios. He visto increíbles mejoras en los resultados de los buscadores tan solo cambiando el esquema de los URLs del sitio. Modificar y reescribir los URLs de un sitio puede ser un poco difícil, y algunos Sistemas Manejadores de Contenido (CMS – Content Managment Systems) hacen más difícil que otros su implementación. Sin embargo vale la pena. 7. Haz que te vinculen Sin embargo, de acuerdo a mi experiencia, los vínculos entrantes son menos importantes entre más específico y único sea el contenido. Por ejemplo, un par de clientes están en lo que podrías llamar un nicho de mercado. No tienen muchos sitios vinculándolos, y aún así comenzaron a posicionarse muy bien en los buscadores una vez les apliqué a sus sitios el conocimiento que estoy compartiendo aquí. 8. Usa un marcado [HTML] válido, semántico, ligero y accesible Un marcado [HTML] de alta calidad te ayudará a aumentar tus posiciones. La accesibilidad también es algo muy importante. El hacer tu sitio más accesible para personas con problemas visuales también te ayudará a que los robots de los buscadores se ubiquen más fácilmente. Recuerda, Google es ciego, así que aun cuando no te interese que la gente ciega use tu sitio (aunque deberías) aún quieres que sea accesible. Esto significa que deberías usar encabezados reales [h1 a h6], párrafos [p] y listas [ul, ol y li], y evitar el usar cualquier otra cosa que interfiera con los robots de los buscadores. Flash y Javascript están bien, siempre y cuando no se requieran para navegar tu sitio y acceder información vital. No escondas tu contenido dentro de archivos de Flash o detrás de un suntuoso menú en Javascript. Prueba tu sitio con Lynx. Navégalo apagando las gráficas, los CSS, el Javascript y el Flash. Si te da problemas, probablemente le causará problemas a los robots de los buscadores. 9. Agrega con cuidado tu sitio a los buscadores Dos directorios que pueden ser importantes para agregar son el Directorio de Yahoo y el Open Directory Project. Se paciente -probablemente tomará varias semanas para que tu solicitud sea procesada, a menos que les pagues para que te listen. 10. No trates de engañar a los buscadores Los buscadores quieren que sus resultados sean acertados, y no les gusta cuando la gente trata de engañarlos. Así que no lo hagas. 11. Evita usar marcos (frames) Cuando alguien sigue un vínculo de la página de resultados de un buscador a un sitio basado en marcos, llegará a un documento huérfano, fuera de su conjunto de marcos padre (frameset). Muy probablemente esto causará confusión, ya que en muchos casos partes vitales del sitio, como los vínculos de navegación, estarán ausentes. Algunos sitios usan JavaScript o código del lado del servidor para redireccionar, a cualquiera que intente cargar un documento fuera de su conjunto de marcos, a la página inicial del sitio. Trabaja sin marcos. En todo caso son malos para la usabilidad. 12. Ten cuidado con la detección de navegadores 13. No pierdas el tiempo con los meta tags Algunos buscadores usan el contenido del meta de descripción para describir tu sitio en los resultados de sus búsquedas, así que si es posible, pon un contenido único y descriptivo para cada documento. Ohh. Eso estuvo demasiado largo para leer ¿Qué sigue? Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Una muy buena guia SEO para principiantes. Me gustaria poder utilizar todo este en el sistema Ucoz

Saludos |

Sitios Web Optimizados para Buscadores 1. ¿Para qué optimizar para la búsqueda? De igual modo, hay empresas con tal prestigio de marca que cualquiera que quiera encontrarlas no tiene más que teclear dicha marca. Para ellas sólo es verdaderamente importante tener en propiedad el dominio de la marca y, a ser posible, "dominios próximos". Así, probablemente CNN no haga demasiados esfuerzos en optimizar su relevancia en búsquedas externas, habida cuenta el valor de sus servicios y que cualquiera supondrá que para acceder a su site sólo va a tener que teclear www.cnn.com. Sin embargo, para empresas que de alguna forma compitan con otras en la Web para ofrecer sus servicios o productos, la relevancia con que aparezcan en las búsquedas de interesados puede ser crucial. La diferencia de visitas que puede tener una empresa con venta on-line de artículos para regalo que aparezca la 2ª o 3ª en una búsqueda de “día del padre” o “regalos nombre” es de órdenes de magnitud mayor que una rival que aparezca la 18, por ejemplo. Y lo que cualquier aprendiz de marketing en la Red sabe es que a más visitas, más posibilidades de venta (aunque haya otros factores muy importantes para el éxito de la venta on-line). Y con la cuasi-monopolización de la búsqueda por Google, se terminó el comprar prioridad en los resultados de las búsquedas. Y si alguien está dispuesto a pagar por aparecer primero en los buscadores que se presten a ello, probablemente no precisará seguir leyendo. Pero si quiere obtener buenos resultados sólo en base a "buenas prácticas", a continuación tiene algunos consejos que seguro van a ayudarle. 2. Título de página representativo del contenido: Un sitio en el que: No están aportando una información valiosa sobre la página a los buscadores que la indizan, de manera que estos se van a encontrar con un monón de páginas que todas se llaman igual, a los que no estamos indicando qué tiene la página exactamente y a los que no estamos ayudando a cualificar nuestas páginas. En términos de usabilidad, el Título es lo primero que se carga de la página y, por tanto, la primera información de la misma que tiene el usuario. Es muy útil si, en tanto se descarga al browser el resto de texto, imágenes, etc., el usuario puede tener una primera información de a qué se refiere la página. 3. "Keywords" que incluyan las palabras que mejor identifiquen el contenido: Sin embargo, debido a que es un trabajo tedioso extraer las palabras clave de cada una de las páginas, es muy frecuente encontrar que: En cualquiera de estos casos el buscador va a buscar las "keywords" de cada página y sólo va a encontrar "ruido" que no va a ayudar en absoluto a establecer los metadatos que cualifican la página. 4. Descripción del contenido en párrafo inicial: Suponen que, después del Title, Keywords y Headline, en el primer párrafo ya se puede tener una idea de que va la página (o el site, si es la Home Page). De manera que, en la medida de lo posible, deberíamos incluir en el primer <p> </p> una breve descripción del contenido de la página, o del objetivo del site (Home Page) que incluya las palabras clave que mejor lo definan. Es bueno seguir la técnica periodística donde cada artículo se estructura de la siguiente forma: Desarrollar los contenidos de esta forma redunda directamente en la usabilidad de los mismos: para el usuario es muy bueno saber lo antes posible si está delante de la página o artículo que buscaba o le pueda interesar, y evitarle que tenga que leer varios párrafos para tener una idea clara de ante qué contenido concreto está. 5. Estructurar los contenidos con títulos y subtítulos de párrafo: Esto es así ya que suponen que el texto se organiza en párrafos con un encabezado que resume el contenido del párrafo dependiente. Así, en principio asúmen que un tag <h1> </h1> es el encabezado de una página, los tags <h2> </h2> son los apartados principales en que se divide la página, los tags <h3> </h3> son los párrafos principales en que se divide cada apartado, y así sucesivamente. Debido a esta forma de entender la página, es muy conveniente utilizar los "headings" de HTML e incluir en ellos las palabras clave de los párrafos dependientes. Y en términos de usabilidad, los "headings" y "subheadings" son muy útiles para estructurar visualmente el flujo de texto de la página que, como ya se ha comentado, es especialmente útil en la lectura rápida de páginas web. 6. No usar Frames ni IFrames: En realidad eran una herramienta arcaica de los primeros tiempos de WWW utilizada las más de las veces para montar un sistema de navegación siempre visible que fuera descargando páginas a un área de datos. Desde hace tiempo esta es una técnica obsoleta, cuya única ventaja es que permite visualizar a la vez la opción de menú pulsada y la página descargada. Y esta ventaja, al margen de que puede implementarse mediante programación en un menú sin frames, se reduce mucho por el hecho de tener Título la página. Un "Breadcrumb" ayuda mucho a aportar la información necesaria para ubicar la página en la estructura de navegación. Y, por contra, las desventajas de utilizar frames son numerosas, tanto en términos de usabilidad general, como en términos de buscadores: Los buscadores como mejor trabajan es con estructuras de páginas simples relacionadas entre ellas, por complejas que sean estas relaciones. De manera que, como norma general, nunca usar Frames o IFrames y, de hacerlo, olvidarnos de buenos rankings en buscadores. 7. Texto descriptivo en los Hiperenlaces: La diferencia que existe en enlazar la página de "Consultas y Sugerencias" de una de estas dos formas: En el primer caso, el hiperenlace no contiene ninguna palabra relacionada con el objetivo o contenido de la página enlazada. El motor no podrá asociar a priori la página enlazada a ningún concepto. De forma análoga en términos de usabilidad el enlace no ofrece ninguna información de destino al usuario: para deducir a dónde le envían deberá detenerse a escudriñar los textos próximos. (Uno de los aspectos de la lectura rápida superficial de páginas web es buscar, casi instintivamente, a dónde se puede navegar desde cada página mediante hiperenlaces). En el segundo caso, el hiperenlace describe el objetivo o contenido de la página enlazada. El motor asociará la página enlazada automáticamente a "Consultas y Sugerencias". Esto que puede parecer no excesivamente importante puede implicar que las relaciones con otras páginas que tiene una página aparezcan catalogadas en el buscador como: O, por el contrario: Dependiendo de como estén descritos los enlaces puede tener mucha más prevalencia en el site el concepto "Pulse aquí" que "El significado de los colores", lo que es un disparate. 8. Peso de Página máximo 80 KBytes: Considerando la descarga de todos los elementos juntos que integrarían la página, el peso y, por tanto el tiempo de descarga, son ya muy considerables para este tamaño, siendo, desde el punto de vista de usabilidad, difícilmente sostenibles pesos mayores. Y desde el punto de vista de los buscadores, al igual que contenidos escasos apenas les proporcionan palabras relevantes, contenidos muy extensos pueden proporcionarles demasiadas, sin criterios para priorizar o valorar si la página es significativa, por lo que es muy probable que la otorgue una relevancia pequeña. 9. Distribuir contenidos en página mediante reglas CSS: Sin embargo existe aún gran recelo de utilizar las características de las CSS's para ubicar y distribuir los elementos y contenedores de la página, entre otras razones, porque positioning no está soportado por algunas versiones de navegadores y casi siempre se aspira a llegar al máximo número de usuarios. Se ha realizado el experimento de diseñar dos sites: Una vez puestos los sites en producción, se catalogaron ambos sites para su inclusión en los mismos buscadores. Unos meses después, el site diseñado enteramente con CSS's tenía muchas más visitas que el realizado de forma tradicional mediante tablas. Hay varias razones para ello: Desde el punto de vista de la usabilidad: 10. Al menos 200 palabras por página: Por el contrario, una página.con sólo titulares y pequeños "abstracts" (resúmenes) adjuntos, relacionados con temas diversos, requerirán un mayor esfuerzo de taxonomización de la página, y en muchos casos, se correrá el riesgo de que el buscador la desestime y la ignore, o que la asigne una valoración muy baja. Al margen de los buscadores, y en términos exclusivos de usabilidad, a los tradicionales argumentos en contra de páginas extensas: También se pueden oponer argumentos a favor de páginas extensas: Si bien pueden responder a una arquitectura adecuada de contenidos, acaban por introducir demasiados "clicks" hasta llegar a un contenido con valor intrínseco: 11. Contenido valioso: Sitios con un diseño precario como Amazon son visitados masivamente por el alto interés de lo que ofrecen, de la misma manera que nadie se preocupa de la usabilidad de Softonic habida cuenta de la ingente cantidad de software gratis que proporcionan, lo que es un incentivo para solventar las posibles dificultades operativas que pudiera implicar. Y esta relevancia de los contenidos la refuerza el hecho de que, para un usuario concreto, la usabilidad es un déficit transitorio, habida cuenta que, si un sitio le interesa, termina pronto por aprender lo que debiera ser evidente: la forma correcta y más cómoda de moverse en él. Pero, ¿qué tiene que ver la calidad del contenido con la valoración que de un sitio o una página haga un buscador? Pues aunque pudiera parecer que nada, el hecho es que tiene mucha importancia, desde luego con Google, el motor de búsqueda estrella de la Web desde hace tiempo. Porque el "core" de Google realiza un continuo análisis entre los millones de páginas que tiene indizadas, asignando dinámicamente mayor valoración a los sites "linkados" por más sites. Y si los sites que enlazan a una página tienen alta valoración en Google, mayor valoración tendrá la página enlazada. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Estrategia para mejorar la Popularidad Web Conseguir enlaces es una de las tareas más laboriosas y aburridas del posicionamiento en buscadores. En ocasiones, se convierte en un trabajo monótono y repetitivo, que en la mayor parte de los casos, no tiene demasiado éxito. Se intentarán describir las formas más comunes de buscar enlaces de nuestro interés, con la idea de mejorar el posicionamiento para búsquedas concretas. No hay ningún caso especial, ni ninguna fórmula mágica, sin horas de dedicación para la construcción de nuestra popularidad web, esta estrategia fallará, como cualquier otra. No es necesario seguir los pasos 1 a 1 por el tiempo que esto podría llevar, pero para un éxito en las búsquedas más competitivas, sería recomendable seguir todos los puntos, localizando todos los enlaces posibles. Popularidad y Posicionamiento en Buscadores ¿Qué es un enlace de calidad? Todo enlace que está fuertemente ligado con los contenidos de nuestra web, si el enlace está en una página reconocida, que tiene buenos resultados en las búsquedas que nos interesan, será todavía más válido. ¿Por qué una popularidad web estable? Los buscadores cambian sus algoritmos continuamente, haciendo pequeñas modificaciones o incluso grandes cambios, no hay más que ver el reciente caso de Google. Una popularidad web basada en enlaces fáciles, posiblemente nos funcione hoy en algunos buscadores, pero no será válida en todos, y en un futuro próximo podríamos vernos perjudicados. Los buscadores tienden a valorar cada vez menos, o incluso nada, este tipo de enlaces, que son muy utilizados para alterar los resultados de sus algoritmos. Una popularidad web estable va a ser aquella que nos permita sobrevivir a lo largo del tiempo a los cambios de los buscadores. Nuestro objetivo deberá ser únicamente posicionarnos con estabilidad en los resultados de búsqueda. La estrategia de posicionamiento mediante construcción de popularidad que sigue a continuación, persigue exclusivamente esto. Sobreviviendo al Nuevo Google En varias búsquedas que he analizado recientemente ("diseño web", "posicionamiento en buscadores", "alta en buscadores"), se puede observar que las páginas con un peor tema, necesitan un número de enlaces muy superior (así por encima, 4 veces más, como mínimo), para tener mejores resultados que páginas con un mejor tema. El tema, además de medirse por los contenidos de las webs, está muy relacionado con quién nos enlaza y a quién enlazamos. Se puede utilizar el comando related:www.dominio.com de Google, y observar si las páginas que se muestran son de nuestra temática o no. Hay muchos casos, páginas a las que no les sale ninguna web relacionada con su tema con ese comando, este grupo de páginas para posicionarse por búsquedas relacionadas, necesitará un número de enlaces entrantes de otras páginas (y con el anchor text adecuado) muy superior a aquellas webs que muestren con el comando related páginas fuertemente ligadas al tema o temas de los contenidos de la página. Otra opción para ver más o menos cual es el tema de nuestra web, es usar los anuncios de Adsense que se generan para una página web concreta. Normalmente salen 5 cuadros, de esta forma se puede hacer una media del número de cuadros que suelen salir relacionados con la búsqueda que estamos analizando, si el número de cuadros es menor de 3 o incluso 2, el tema de esa web no será demasiado bueno. Si el número de anuncios que están relacionados con los contenidos de nuestra web es superior a 3 o 4, nuestro tema estará bien definido. Lo ideal, claro está, y que debería ser, es un 5. Que los 5 cuadros de Adsense anuncien páginas ligadas a los contenidos de nuestra web. Este es otro de nuestros objetivos, y uno de los síntomas de que nuestra popularidad web es estable. Una Authority suele ser una página con muchos enlaces entrantes desde otras que están ligadas con sus contenidos. Un Hub además de muchos entrantes tiene enlaces salientes, los directorios importantes suelen cumplir esto en algunas de sus categorías. Tanto Hubs como Authorities, parecen tener resultados positivos en el nuevo google. El número de enlaces relacionados con sus contenidos puede ser un claro indicativo del motivo. Nos interesan los enlaces de Authorities y Hubs, por encima de cualquier otro. Método para una Popularidad Web Estable Para la página optimizada para diseño web, seguiríamos algo así: Diseño Web Para la página optimizada para Alta en Buscadores, seguiríamos algo así: Alta en Buscadores Para la página optimizada para Posicionamiento en Buscadores, seguiríamos algo así: Posicionamiento en Buscadores Cada uno escogería los anchor text como le sean adecuados, entre 3 y 5 variantes por cadena de búsqueda. Este paso no deberíamos saltarlo nunca. Es obligatorio darse de alta en DMOZ y el directorio de Yahoo!. Sólo esos dos, a lo largo del tiempo, nos darán muchos enlaces válidos. Debemos pensar cuidadosamente el anchor text y la descripción con la que nos daremos de alta en esos dos directorios, ya que a la larga habrá decenas de sitios que utilicen esas descripciones y los propios Google y Yahoo! para mostrarnos en sus búsquedas. Estos no son los únicos directorios importantes, tenemos también terra entre otros y todos aquellos locales en los que podamos añadirnos. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

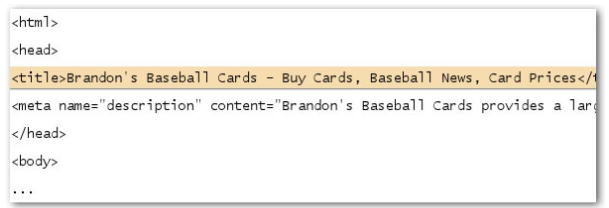

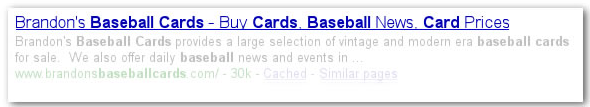

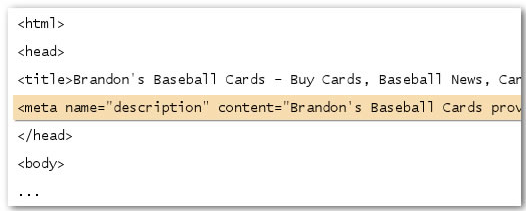

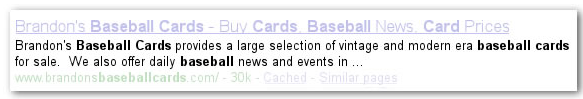

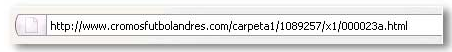

Optimización Google La etiqueta title proporciona a los usuarios y a los motores de búsqueda cual es el tema de una página en particular. El título de tu página de inicio puede incluir el nombre de tu sitio Web y podría incluir otros trozos de información importante, como la ubicación física de la empresa o tal vez algunos de sus servicios principales u ofertas. El título de la página principal de nuestro sitio, muestra el nombre de la empresa y tres áreas de enfoque. Nuestra página Web aparece como resultado de ello, y como vemos el título aparece en la primera línea. Después de tener claro los conceptos y la prioridad de la etiqueta <title> en los buscadores, os dejo con una lista de buenas prácticas para la optimización en Google. Buenas prácticas para la etiqueta <title> • Crear títulos únicos para cada página: Cada página debe tener su propio título, ya que ayuda a Google a interpretar que se trata de páginas distintas del sitio. • Utilice un [b]title breve, pero descriptivo:[/b] Los títulos pueden ser cortos e informativos. Si el título es demasiado de largo, Google mostrará sólo una parte de ella en el resultado de la búsqueda. La etiqueta meta description (<meta name=”description”) ofrece a Google y a otros motores de búsqueda un resumen de lo que trata la página. Considerando que en la etiqueta <title> podemos usar unas pocas palabras o una frase, la descripción de la página si puede contener una frase o dos o un pequeño parrafo. En las Herramientas para Webmasters de Google podemos encontrar un artículo práctico sobre las meta-tags. La descripción nos muestra una breve reseña de lo que ofrece la página Web. La descripciones (description) son importantes porque Google podría utilizarlas como fragmentos de sus páginas de resultado. Tenga en cuenta que decimos “podría”, porque Google puede optar por utilizar una sección de su página visible si hace un buen trabajo de concordancia con la consulta del usuario. Después de haber hecho la consulta “baseball cards”, nuestra página web aparece como un resultado, con parte de su descripción del meta-tag description que habíamos introducido. Buenas prácticas para el meta tags description • Utiliza descripciones únicas para cada página: Disponer de una descripción diferente para cada meta-etiqueta, la página ayuda a los usuarios y a Google, especialmente en las búsquedas que los usuarios pueden abrir múltiples páginas de su dominio (por ejemplo, las búsquedas utilizando el operador site. Si su sitio contiene miles o incluso millones de páginas, introducir a mano la descripción metacódigos probablemente no es factible. En este caso, se puede generar automáticamente la descripción basada en el contenido de cada página. Hubo un tiempo en que las meta-tags fueron un popular método para otorgar relevancia a las webs, pero murieron víctimas de los webmasters sin escrúpulos. Las etiquetas meta solían ser parte del algoritmo para organizar los resultados de una búsqueda, pero debido a la facilidad con que el autor del sitio podía manipularlas, son pocos los buscadores que actualmente hacen uso de ellas para posicionamiento. Sin duda, la más importante y la más utilizada en su momento fue la etiqueta meta Keyword. La etiqueta meta keywords tiene el siguiente formato: Esta etiqueta contiene un listado de palabras y frases clave, referentes al contenido de la página. La idea es que cualquiera (incluidos robots de búsqueda) pueda entender de qué temas se tratan en la página mediante estas keywords. Los buscadores ignoran esta información (o le dan muy poca importancia) para efectos de posicionamiento, pero es posible que se penalice a la página si se hace un uso poco adecuado de esta meta etiqueta. Por ejemplo repitiendo en la etiqueta muchas keywords innecesariamente, lo que puede ser considerado como span.. Como antes he comentado, ésta fue una de las etiquetas más abusadas, y por esa razón casi todos los buscadores la ignoran. Entonces, ¿hay alguna razón para seguir usándola? Yo creo que hay dos: • Es posible que algún buscador le dé alguna importancia Si en este punto sigues interesado en seguir utilizando esta etiqueta aquí tienes una serie de trucos y consejos: • En vez de palabras clave, puedes utilizar frases clave. Como ya hemos hablado hay varias recomendaciones para mejorar la optimización en Google y otros buscadores. Si creamos URLs más sencillas serán mas atractivas. Los usuarios que visitan tu sitio pueden sentirse intimidados por URLs muy largas y raras con pocas palabras reconocibles. Las URL de este tipo pueden ser confusas. Además, los usuarios pueden creer que una parte de la URL no es necesaria, sobre todo si la URL muestra muchos parámetros irreconocibles. Podrían dejar fuera una parte, rompiendo así el enlace. Si la URL contiene palabras relevantes, se proporciona a los usuarios y a los motores de búsqueda información adicional sobre la página. Las palabras resaltadas podrían informar al usuario o al motor de búsqueda sobre la página incluso antes de hacer clic en el enlace. También tenemos que tener en cuenta que la URL de documento se muestra como parte de un resultado de búsqueda en Google, después del título del documento y del fragmento. Al igual que el título y el fragmento, las palabras en la URL del resultado de búsqueda aparecerán en negrita si coinciden con la consulta del usuario. Si queréis saber más sobre las malas prácticas de las estructuras URL dinámicas podéis ver los requisitos de Google. Prácticas recomendadas sobre estructuras URL • Crea una estructura de directorios simple. Utiliza una estructura de directorios que organice el contenido y facilite a los usuarios que visitan tu sitio el saber dónde están dentro de éste. Trata de usar la estructura de directorio para indicar el tipo de contenido que se encuentra en esa URL. • Proporciona una versión de la URL para llegar a un documento. Para Evitar que los usuarios enlacen a una versión de la URL y otros enlacen a otra versión diferente (esto podría dividir la reputación del contenido entre ambas URL), céntrate en usar y referenciar una URL en la estructura y en los enlaces internos de tus páginas. Según Matt Cutts, si hay más de cinco palabras, el algoritmo de Google distribuye el peso en cada una de ellas y no termina de darles credibilidad. Os dejo una lista de puntos básicos que debemos tener en cuenta a la hora de crear URLs en nuestra Web: Bueno, todas estas recomendaciones sobre la estructura URL no van a mejorar en un 100% la optimización en buscadores de nuestra Web. Pero si en gran medida, tanto para los motores de búsqueda, como para la navegación de los usuarios que visitan de nuestra página o acceden a ella desde los resultados de búsqueda. Como dice Javier Casares, los buscadores están gastando muchos esfuerzos en valorar la calidad de nuestros contenidos mediante enlaces externos, pero debido a la gran cantidad de resultados y contenidos no deseados se está volviendo a dar mucha importancia a los contenidos originales bien redactados y formateados. Por ello, la mejor manera para conseguir que nuestra página esté bien posicionada, es crear una suma de coincidencias. Es decir, ofrecer al buscador una sucesión de pistas para que se de cuenta de que nuestra página habla de unos contenidos relacionados con determinadas palabras clave. La densidad de texto consiste en generalizar esta fórmula dentro de los textos de nuestra web, de manera que evitemos el uso de sinónimos y reiteremos en lo posible las palabras clave que nos interesan. Así pues podemos decir que, la densidad de palabras clave es el número de apariciones de una keyword en el total de palabras que componen un texto. Sabiendo esto, cuando redactes los contenidos de tu web es aconsejable tener una densidad de palabras no inferior a 2% ni superior a 5% para cada keyword. Existen varias herramientas para analizar la densidad de palabras clave de los sitios web, las que pongo a continuación te pueden servir de referencia. • http://www.ranks.nl/tools/spider.html Prácticas recomendadas Prácticas poco recomendadas Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

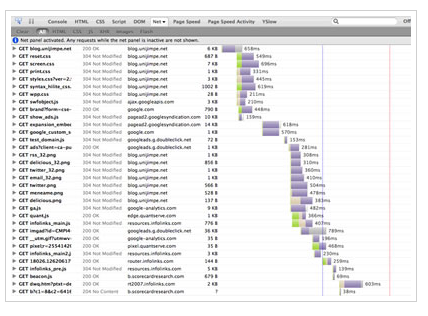

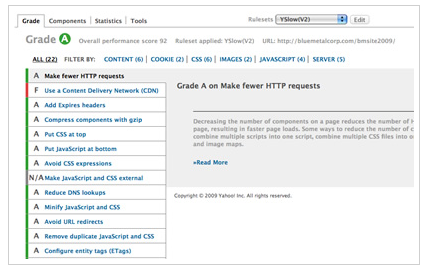

Optimizar Carga de Páginas Web La optimización de los sitios web es un punto muy importante para mejorar el rendimiento de cualquier sitio web. Según los datos, basados en los estudios hechos por el equipo de optimización de Yahoo han llegado a definir una regla: Sólo el 10-20% del tiempo de respuesta se utiliza en descargar el documento HTML. Esto significa que si logramos optimizar la carga de todos los elementos de la pagina web, tendríamos el 80% de la velocidad de carga bajo nuestro control, con el consiguiente aumento considerable en la velocidad de carga de una web. Reglas para Optimización • Reducir las peticiones HTTP • Agregar headers de Expiración • Utilizar compresión Gzip • Colocar los Estilos en el Header • Colocar los Scripts en el Footer • Poner Javascript y CSS en archivos externos • Reducir las búsquedas DNS • Minificar archivos Javascript y CSS • Evitar las Redirecciones • Configurar los eTags • Remover Scripts duplicados • Optimizar las Imágenes • Utilizar dominios libre de Cookies Herramientas para la Optimización • Firebug • YSlow • Page Speed

Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

Iniciación al posicionamiento web en los buscadores ¿Qué es el posicionamiento de páginas web? ¿Por qué es importante el posicionamiento en los buscadores? ¿Qué hay que hacer para posicionar una página web? Ahora bien, antes de empezar a hablar de esas técnicas, conviene tener unos conceptos previos claros y unos objetivos realistas sobre lo que queremos conseguir al posicionar nuestra web: Funcionamiento de un buscador Para indexar las páginas web que hay en Internet, los buscadores utilizan unas aplicaciones llamadas arañas (o spiders, robots, etc.) que visitan periódicamente los sitios que tienen ya almacenados en sus bases de datos en busca de nuevos contenidos, modificaciones, enlaces a seguir o páginas que ya no existen (en este último caso para borrarlas). Todas las páginas nuevas que visita el robot, las modificaciones que detecta, etc, las va guardando en la bases de datos, así consiguen la mayoría de ellos mantenerlas actualizadas. Palabras clave o keywords Por este motivo, el análisis de palabras clave es un paso previo muy importante de cara al posicionamiento en los buscadores. Si no dirigimos nuestros esfuerzos a las palabras clave adecuadas, estaremos perdiendo el tiempo. En este sentido, es importante tener en cuenta siempre lo siguiente; las palabras únicas más generales (e incluso no tan generales), como por ejemplo, “ordenadores”, ofrecen mucha competencia, es decir, que muchas páginas intentan aparecer en los primeros puestos cuando alguien las busca. Por el contrario, los usuarios son cada vez mejores buscadores de información y utilizan con poca frecuencia palabras generales a favor de frases más precisas que les arrojen resultados de mayor relevancia para sus necesidades. Por eso, a la hora de hablar de palabras clave sería mejor referirnos a frases clave y, en consecuencia, guiar nuestros esfuerzos a posicionar frases y no palabras sueltas. Esto nos dará mejores resultados. Por suerte, existen en el mercado diversas herramientas que nos ayudarán a decidir sobre qué palabras (frases) clave trabajar para mejorar el posicionamiento de nuestra web en los buscadores. Entre ellas, una de las más conocidas es el Wordtracker Keyword Generator (en inglés), también puedes utilizar la herramienta para palabras clave de Google. En ambas, puedes introducir las palabras clave que te interesen y el programa te devuelve una lista de palabras similares que pueden ser analizadas de diversas formas. Un último punto a considerar en cuanto a las palabras y frases clave, es decidir cuántas utilizamos. Hay que buscar soluciones realistas, pero en general, por cada página web con bastante contenido que tengamos (se entiende como información, no imágenes, enlaces, juegos, ni publicidad), es recomendable utilizar de una a tres frases claves. Hay que resaltar aquí que es aconsejable utilizar palabras o frases distintas para cada página de la web, dependiendo del contenido específico de cada una. Además, obtendremos mejores resultados si ponemos nuestro esfuerzo en frases que, aunque menos buscadas, tengan menor competencia, que frases con mucha competencia ya que con ellas será muy difícil el posicionamiento en los buscadores, por lo que no será muy efectivo. Centrarse en los principales buscadores Tener paciencia y seriedad Ofrecer contenidos de calidad Cuando redactes tu página no olvides incluir en el texto de forma coherente las palabras clave que elegiste con anterioridad, siempre que mantengas sentido en tu página y no se note que están puestas de forma forzada, etc. Los contenidos deberían tener una densidad del 2% al 7% para cada palabra o frase clave utilizada. No intentes escribir tus palabras clave demasiadas veces en el texto porque puede ser considerado spam y penalizar tu página (evita que la densidad de cada una sea superior al 20%). Una buena herramienta para saber la densidad de palabras clave de tu web es keyword density & prominence. Conseguir buenos enlaces No obstante, los enlaces naturales no son los únicos válidos para el posicionamiento en los buscadores, los enlaces de directorios también pueden sernos útiles. Aunque estos no aumentarán demasiado el tráfico de tu web, ayudarán con el tiempo a subir posiciones, siempre y cuando sean buenos directorios (por ejemplo Dmoz) en cuanto a contenido y al tipo de enlaces que realizan. Además, debemos evitar en lo posible repetir el mismo título y descripción en cada directorio en el que demos de alta la web, ya que lo más importante son los enlaces naturales, y así no lo parecerían. Por otro lado, si tienes una web con mucho y buen contenido, puede ser interesante realizar artículos para otras páginas de tu misma temática, ya que los enlaces que se consiguen así son muy valorados por los buscadores, además de serte útil para la promoción web (normalmente en la página del artículo que proviene de otras fuentes se indica el nombre del autor y la dirección de su página web). A la hora de recibir un enlace de otra página, fíjate bien en cómo lo hacen. Esto es, debes fijarte en el “anchor text” (el texto del enlace) y el tipo de enlace. En el anchor text debería figurar alguna palabra clave relacionada con tu página. Por ejemplo, para una web de cocina mediterránea, sería muy conveniente que precisamente fuera “cocina mediterránea” el texto del enlace y no “pincha aquí” o “enlace”. Además, presta atención al código de tu enlace, que tenga un aspecto parecido a este: O si es una imagen: Sobre todo, asegúrate de que tu enlace no está hecho con javascript, porque los buscadores no pueden leerlos y no te servirá de nada de cara al posicionamiento. Los enlaces javascript son más o menos así: También hay que tener cuidado de que no hayan incluido el atributo “nofollow” dentro de la etiqueta <a>, ya que estos enlaces no son seguidos por los buscadores. Por último, decir que es importante no conseguir muchos enlaces de golpe, sino que ir trabajando en este aspecto calmadamente (por ejemplo, conseguir 10 enlaces el primer mes, 15 el segundo, 30 el tercero, etc.) para evitar que los buscadores interpreten este hecho como que estamos intentando manipular sus resultados y nos penalicen. MetaTags Título y etiquetas de encabezado Ni que decir tiene que es precisamente el título lo que primero ve una persona en los resultados de búsqueda y lo que le tiene que impactar o interesar para decidir entrar en tu página. Incluir un mapa web Evita la utilización de archivos flash innecesarios, a los buscadores les cuesta mucho indexarlos y en la mayoría de los casos no lo hacen. Lo mismo pasa con los archivos pdf, que aunque presentan menos problemas que los primeros, también pueden crear dificultades de indexación. Por su parte, el código javascript presenta otro problema para los buscadores ya que la mayoría no puede seguir los enlaces que contienen, por lo que si tu menú está hecho en javascript probablemente sólo conseguirán indexar tu página principal. Ceñirse a los estándares web Tamaño máximo de páginas y enlaces Monitorizar la web, posicionamiento continuo Además, en el tema del posicionamiento de páginas web, constantemente salen cosas nuevas y quedan obsoletas las anteriores, por lo que puede ocurrir que lo que te resultó útil en su momento, ahora no te sirva para nada o incluso te perjudique. Razón más que suficiente para mantenerse al día en este tema y renovarse continuamente. La penalización de webs que realizan prácticas no éticas para posicionarse en los primeros resultados de búsqueda, es una estrategia que utilizan los buscadores para ofrecer resultados más interesantes a sus usuarios. Cuando se detecta que una página está realizando acciones no permitidas, se le penaliza, lo cual puede consistir en hacerla perder posiciones en las búsquedas o incluso eliminarla de los resultados y desindexarla. Entre los motivos que existen para ser penalizado, tenemos: 1. Texto oculto. Texto oculto Webs duplicadas Enlaces artificiales • Realizar spam en blogs y libros de firmas, escribiendo en ellos con la única intención de dejar en enlace a la web. Cloaking y doorways Las doorways son un caso particular de Cloaking, en el que se realizan páginas optimizadas con el único fin de obtener un buen posicionamiento web en buscadores. Normalmente, cuando el usuario intenta acceder a ellas es redireccionado a la página “de verdad” mediante un enlace javascript (los buscadores no pueden leerlos), mientras que cuando el buscador accede a la página se le permite navegar por ella y al no poder leer el enlace javascript almacena la página optimizada para él. Aunque éstas técnicas puedan parecer atractivas, no la uses, puesto que cada día los buscadores implementan nuevos métodos de detección para ellas, por lo que tarde o temprano tus páginas serán penalizadas. Las vírgenes tienen muchas navidades pero ninguna Nochebuena.

|

| |||

Si mejor dedico mi tiempo en generar contenido que dar de alta en los directorios.

Si mejor dedico mi tiempo en generar contenido que dar de alta en los directorios.